LLMOps 가이드

by Stephen M. Walker II, 공동 창립자 / CEO

LLMOps(대형 언어 모델 운영)란 무엇인가?

LLMOps는 OpenAI의 GPT-4, Google의 Palm, Mistral의 Mixtral과 같은 대형 언어 모델(LLM)을 프로덕션 환경에서 관리하는 데 전념하는 기계 학습 운영(MLOps) 내의 전문 분야입니다.

LLMOps는 배포를 간소화하고 확장성을 보장하며 LLM과 관련된 위험을 완화합니다. LLMOps는 텍스트를 이해하고 생성하며 예측하기 위해 심층 학습과 방대한 데이터 세트를 활용하는 LLM이 제기하는 독특한 과제를 해결합니다. LLM의 부상은 이러한 고급 AI 알고리즘을 개발하고 구현하는 비즈니스의 성장을 촉진했습니다.

LLMOps의 주요 구성 요소에는 데이터 관리, 프롬프트 엔지니어링, 모델 미세 조정, 모델 배포, 모델 모니터링 등이 포함됩니다. 데이터 엔지니어링, 데이터 과학, ML 엔지니어링 등 팀 간의 협업과 모든 프로세스를 동기화하고 함께 작동하도록 유지하는 엄격한 운영 규율이 필요합니다.

모델 배포 후 LLM 사용은 모델의 성능을 유지하고 잠재적인 문제를 해결하기 위해 모델을 모니터링하고 업데이트하는 것을 포함하므로 LLMOps의 일부입니다.

애플리케이션 개발자를 위한 LLMOps의 주요 측면은 다음과 같습니다:

- 프롬프트 엔지니어링 — 언어 모델의 응답을 안내하는 잘 설계된 프롬프트를 작성합니다.

- LLM 앱 성능 최적화 — 챗봇, 프로그래밍 도우미 또는 변환 프롬프트와 같은 애플리케이션에 생성 프롬프트를 통합하고 최적화합니다.

- LLM 평가 — 품질을 보장하고 문제를 해결하기 위해 메트릭을 사용하여 모델 및 앱 성능을 정기적으로 평가합니다.

- LLM 관찰성 — 모델 배포 후 실시간 데이터 포인트를 수집하여 모델 성능 저하를 감지합니다.

데이터 및 ML 팀을 위한 LLMOps는 고전적인 MLOps를 직접적으로 반영하며 다음을 포함합니다:

- 모니터링 — 모델 성능, 근거성, 토큰 소비 및 인프라 성능을 지속적으로 추적합니다.

- 미세 조정 — 성능을 개선하고 특정 사용 사례를 해결하기 위해 모델 가중치와 하이퍼파라미터를 조정합니다.

- 배포 — 웹 서비스나 모바일 앱과 같은 애플리케이션에 모델을 통합합니다.

- 유지 관리 — 모델을 최신 상태로 유지하고 효과적으로 유지하기 위해 신선한 데이터로 업데이트하고 필요에 따라 미세 조정합니다.

LLMOps는 프로덕션에서 LLM을 배포하고 관리하는 데 중요한 측면으로, 효율적인 LLM 배포, 모니터링 및 유지 관리를 가능하게 하여 최적의 성능과 사용자 만족을 보장합니다.

이 가이드에서는 LLMOps의 실용적인 측면을 탐구하고 주요 구성 요소, 모범 사례 및 실제 응용 프로그램을 살펴봅니다. 전문가들이 출력물을 정렬하고 유용성을 향상시키며 이러한 강력한 모델의 일관된 높은 성능을 유지하는 방법을 밝혀냅니다.

주요 요점

-

고전적인 ML 워크플로우 — 데이터 관리 및 전처리, 모델 미세 조정/적응, 모니터링/유지 관리는 효과적인 LLMOps 워크플로우의 핵심 구성 요소입니다.

-

최적화 — 프롬프트 엔지니어링 및 검색 증강 생성과 같은 기술은 LLM을 작업에 적응시키고 지식 격차를 해소하기 위한 모범 사례입니다.

-

벤치마킹 — 정기적인 모델 평가/벤치마킹은 시간이 지남에 따라 최적의 LLM 성능을 보장합니다. 개인정보 보호 및 규정 준수 규정을 준수하는 것도 중요합니다.

-

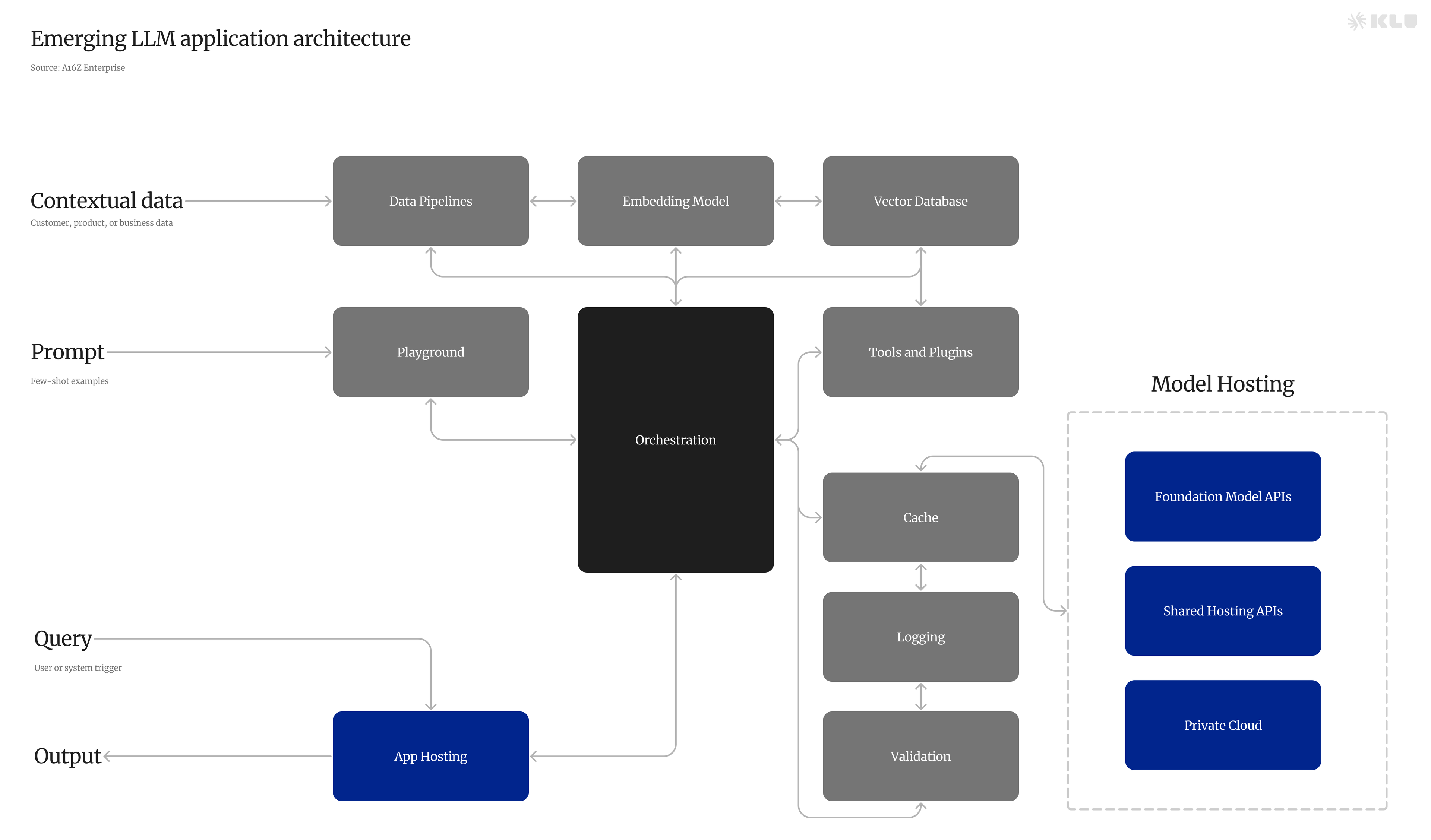

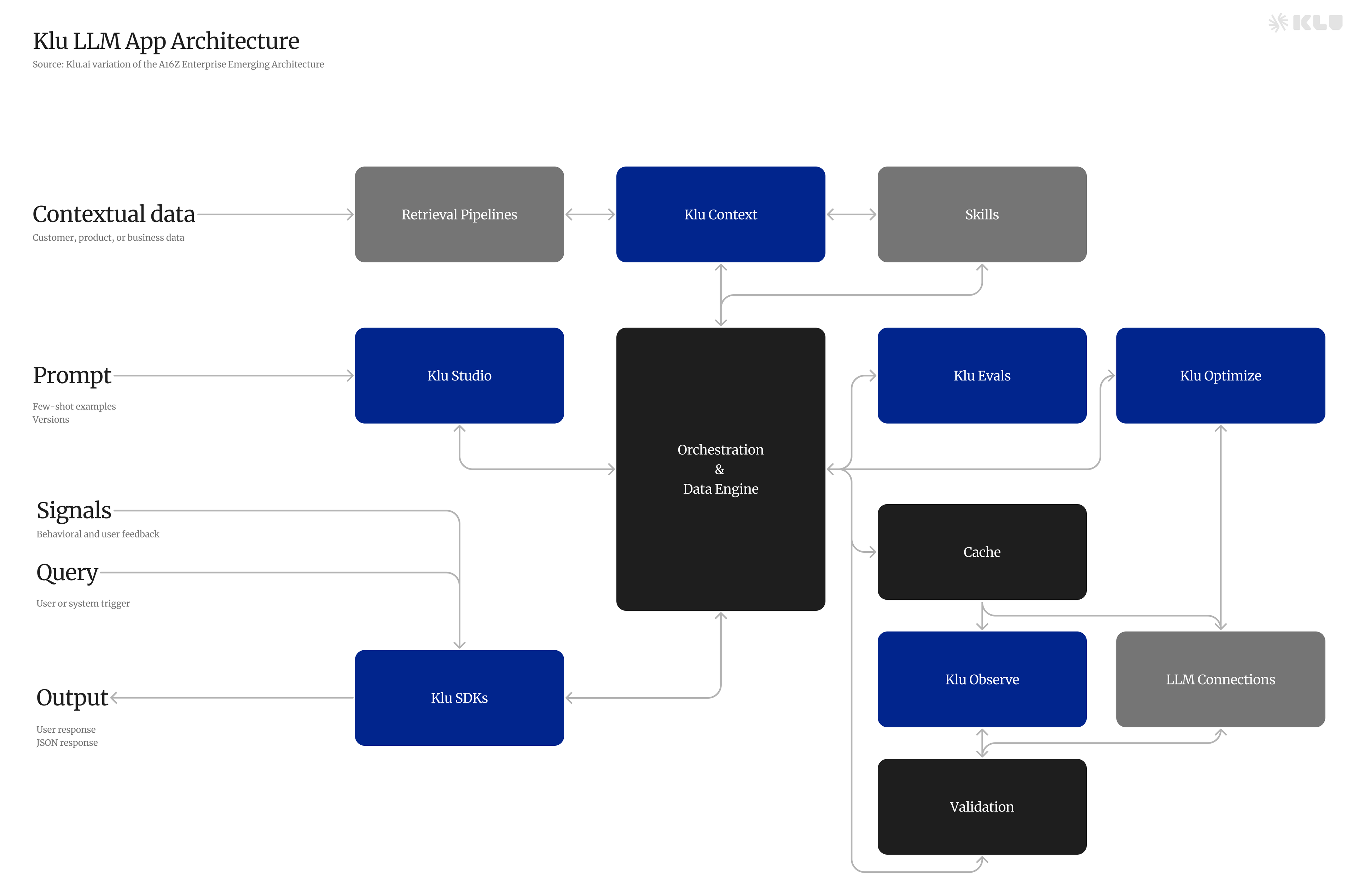

오케스트레이션 — 오케스트레이션 플랫폼, 프레임워크, 라이브러리 및 관찰성 도구는 효율적인 LLM 개발, 배포 및 유지 관리를 가능하게 합니다.

LLMOps의 출현

특히 LLM을 포함한 기계 학습 모델의 사용 증가로 인해 효율적인 관리 및 배포 전략이 필요하게 되었습니다. LLM 또는 기초 모델은 대형 텍스트 데이터 세트에서 학습하여 문법, 의미 및 맥락을 학습하기 위해 심층 학습을 사용합니다. 텍스트 관계를 이해하는 이 능력은 LLM이 문장에서 다음 단어를 예측할 수 있게 하여 현대 AI 시스템에 필수적입니다.

그러나 그들의 수명 주기를 관리하고 다양한 작업에서 성능을 최적화하려면 LLMOps가 수행하는 전문 기술과 도구가 필요합니다.

LLMOps는 LLM의 수명 주기를 관리하고 이러한 모델을 프로덕션에 배포하고 유지 관리하는 특정 요구 사항을 충족하는 포괄적인 접근 방식입니다. 데이터 보호를 보장하면서 특정 작업에 맞게 사전 훈련된 언어 모델을 맞춤화하는 데 중점을 둡니다.

LLMOps는 사용자가 다음을 수행할 수 있는 협업 환경을 촉진합니다:

LLM의 과제

대형 언어 모델(LLM)은 자연어 처리에서 변혁적이며 챗봇, 콘텐츠 생성 및 기계 번역과 같은 애플리케이션을 지원합니다. 이러한 모델은 보다 자연스럽고 직관적인 커뮤니케이션 기능을 제공하여 인간-기계 상호 작용을 향상시킵니다.

그러나 LLM은 그 효과를 극대화하기 위해 해결해야 할 중요한 과제에 직면해 있습니다.

-

언어 모호성 — 자연어의 모호성은 LLM이 오해하여 잘못된 출력을 초래할 수 있습니다. 이를 해결하려면 LLM이 맥락을 깊이 이해하고 정확한 가정을 할 수 있어야 합니다.

-

환각 및 편향 — LLM은 근거 없는 출력물을 생성하거나 훈련 데이터의 편향을 반영할 수 있습니다. 이러한 문제를 완화하려면 균형 잡힌 데이터 세트를 사용하고 데이터 증강 및 정규화와 같은 기술을 적용해야 합니다.

-

계산 비용 및 지연 — LLM의 계산 요구 사항은 높은 비용과 잠재적인 지연을 초래하여 사용자 경험과 LLM의 실제 배포에 영향을 미칠 수 있습니다. 따라서 계산 효율성을 최적화하는 것이 중요합니다.

-

완료 정렬 — LLM 출력을 사용자 의도에 맞추는 것은 어려운 일입니다. 이는 생성된 완료가 관련 있고 정확하도록 보장하기 위해 정교한 알고리즘과 모델, 작업에 대한 명확한 이해가 필요합니다.

-

작업 능력 — LLM은 최적의 성능을 발휘하기 위해 특정 작업에 대한 미세 조정이 필요한 경우가 많습니다. 이 과정은 복잡할 수 있으며 모델과 작업 모두에 대한 철저한 지식이 필요합니다.

-

지식 격차 — LLM은 최신 지식이나 도메인별 전문 지식을 보유하지 않을 수 있어 출력에 격차가 발생할 수 있습니다. 데이터 증강, 전이 학습 및 검색 증강 생성 모델과 같은 기술은 이러한 격차를 해소하는 데 도움이 될 수 있습니다.

LLMOps의 주요 구성 요소

LLMOps는 LLM이 직면한 과제를 해결하고 최적의 성능을 보장하기 위해 데이터 관리 및 전처리, 검색 시스템, 모델 미세 조정 및 적응, 배포 및 모니터링, 프롬프트 버전 관리 및 평가의 다섯 가지 주요 구성 요소를 포함합니다.

이러한 구성 요소를 효과적으로 구현하면 LLMOps는 LLM의 개발, 배포 및 유지 관리를 단순화하여 조직이 이러한 강력한 모델의 잠재력을 최대한 활용할 수 있습니다.

데이터 관리 및 전처리

효과적인 데이터 관리 및 전처리는 데이터 수집, 정리 및 조직을 포함하여 LLM 교육에 필수적입니다. 데이터 품질과 무결성을 보장하는 것은 LLM의 성능에 직접적인 영향을 미치기 때문에 필수적입니다. 맞춤법 검사, 레벤슈타인 거리 계산, 중복 제거 및 이상치 제거와 같은 기술은 데이터 세트를 정제하는 데 일반적으로 사용됩니다.

또한 데이터 저장 및 보안 조치(데이터 암호화 및 액세스 제어 등)를 구현하여 민감한 정보를 보호하고 특히 도메인별 데이터를 처리할 때 데이터 보호 규정을 준수해야 합니다.

검색 시스템

검색 시스템은 LLMOps에서 검색 증강 생성 기술의 중추 역할을 합니다. 이러한 시스템은 방대한 데이터 풀에서 관련 정보를 검색하도록 설계되어 LLM의 외부 지식 소스로 작용합니다. 검색 시스템을 통합함으로써 LLM은 훈련 데이터에 존재하지 않을 수 있는 추가 정보를 액세스하고 통합하여 지식 기반을 강화하고 출력 품질을 향상시킬 수 있습니다.

벡터 데이터베이스는 복잡한 언어 기능을 나타내는 고차원 데이터 벡터를 효율적으로 처리하여 LLMOps 검색 시스템에서 중요한 역할을 합니다. 이러한 데이터베이스는 정확성과 속도의 균형을 맞추어 유사성 검색을 확장하여 LLM이 필요한 정보에 빠르게 액세스할 수 있도록 하여 응답 시간을 손상시키지 않고 콘텐츠 품질을 향상시킵니다.

모델 미세 조정 및 적응

미세 조정 및 프롬프트 엔지니어링을 통해 특정 작업에 대해 사전 훈련된 LLM을 적응시키는 것은 원하는 출력을 얻고 작업 성능을 향상시키는 데 필수적입니다. 미세 조정에는 적절한 모델 아키텍처 선택, 모델 훈련 최적화 및 모델 성능 평가가 포함됩니다.

반면 프롬프트 엔지니어링은 작업에 특정한 프롬프트를 설계하는 데 중점을 둡니다. 이러한 접근 방식을 결합함으로써 LLM은 다양한 작업에 대해 정확하고 관련성 있는 출력을 생성하도록 맞춤화할 수 있습니다.

배포 및 모니터링

프로덕션 환경에서 LLM을 배포하고 감시하는 것은 성능 유지, 문제 해결 및 규정 준수를 보장하는 데 필수적입니다. 지속적인 통합 및 배포(CI/CD) 파이프라인은 테스트 및 모델 배포 프로세스를 자동화하여 모델 개발 프로세스를 용이하게 합니다.

정확도, F1 점수 및 BLEU와 같은 적절한 메트릭을 사용하여 정기적인 모델 평가 및 벤치마킹은 모델 성능을 평가하고 성능 문제를 감지하고 수정하는 데 중요합니다. 모델 모니터링을 구현하면 이 프로세스를 더욱 향상시킬 수 있습니다.

또한 GDPR 및 CCPA와 같은 데이터 보호 규정을 준수하고 데이터 프라이버시를 유지하는 것은 책임 있는 LLM 배포 및 모니터링의 필수적인 측면입니다.

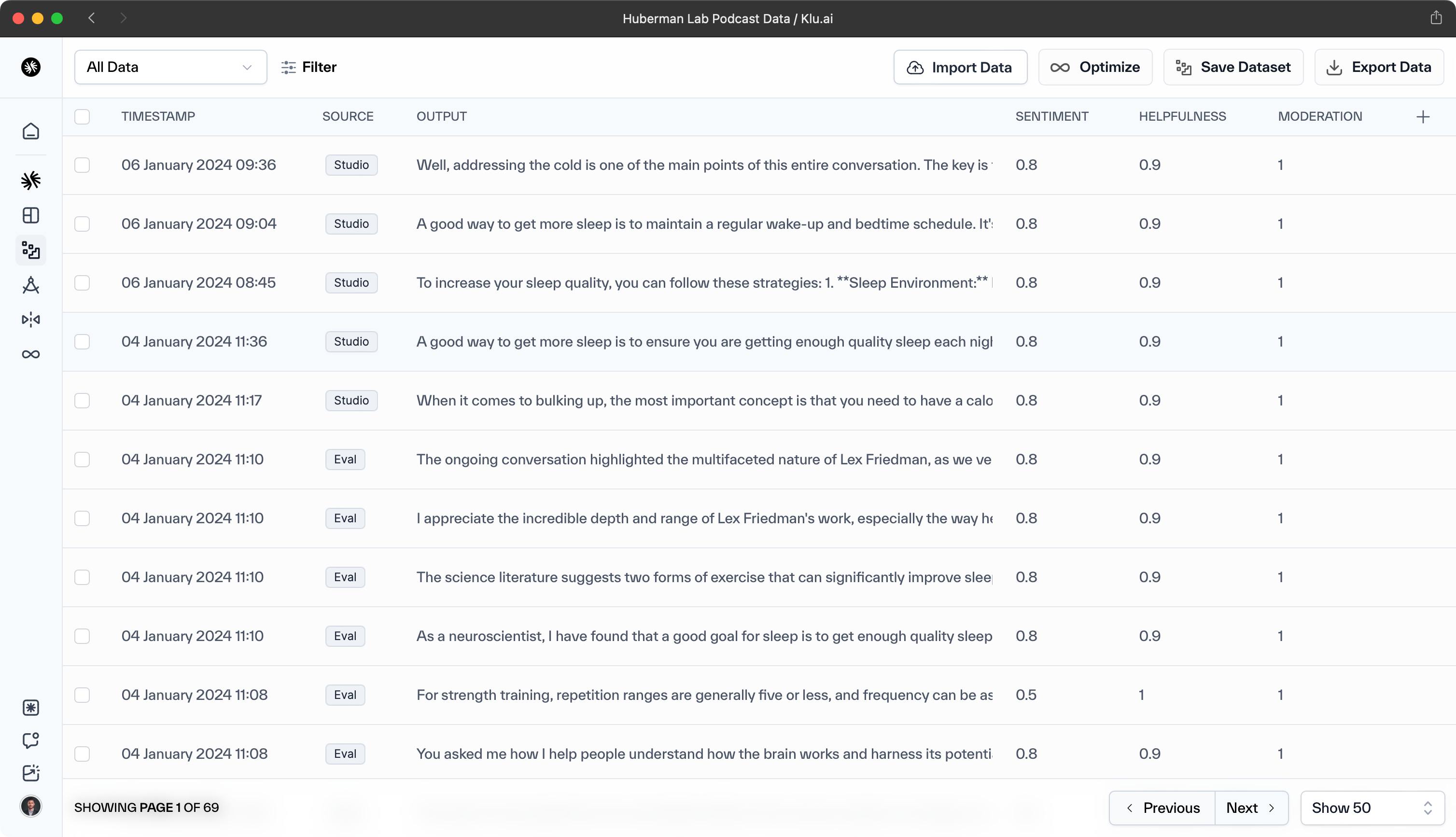

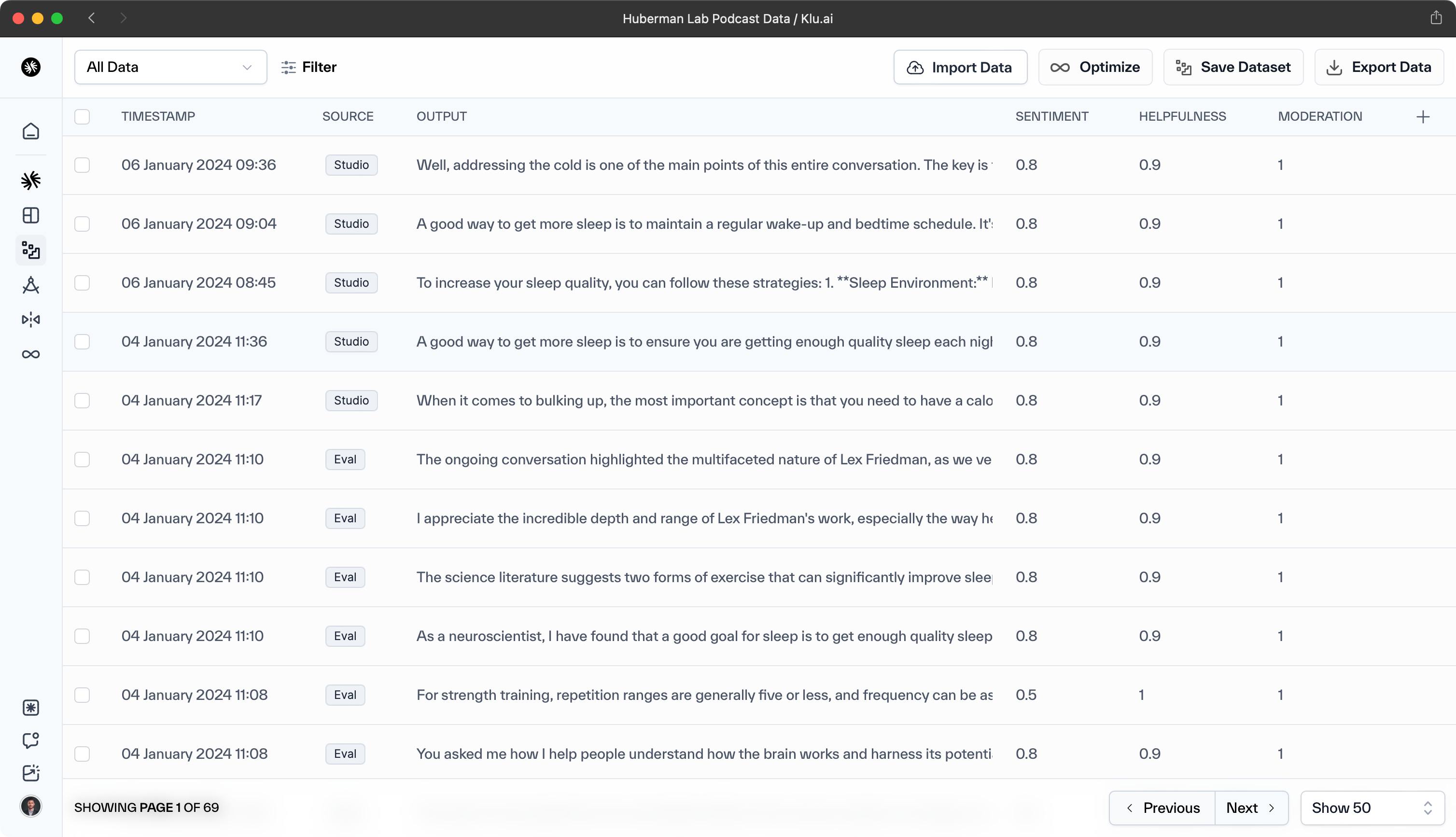

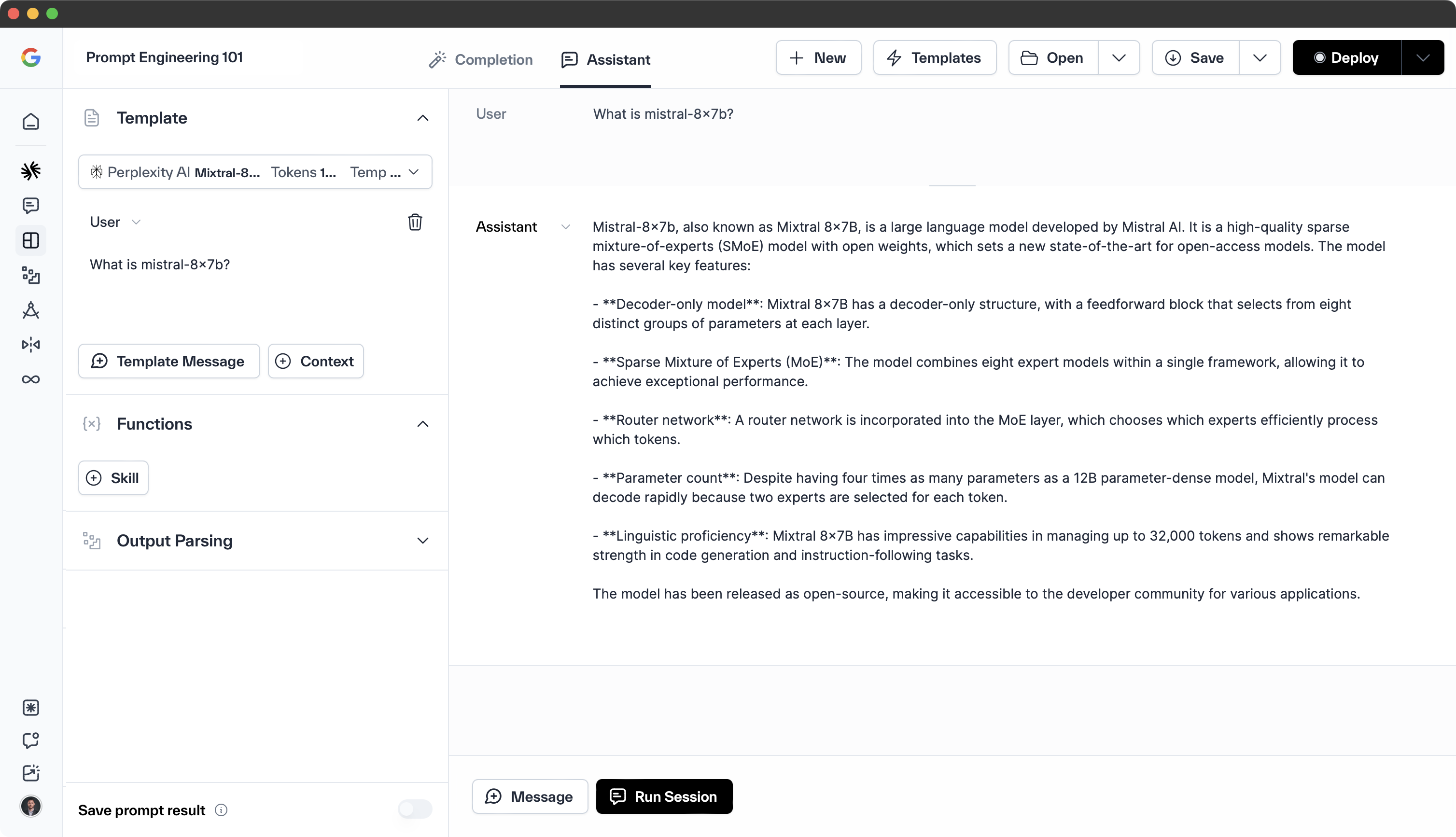

프롬프트 버전 관리 및 평가

프롬프트 버전 관리는 LLM을 위한 다양한 버전의 프롬프트를 생성하고 관리하는 것을 포함합니다. 이 프로세스를 통해 데이터 과학자는 다양한 프롬프트를 실험하고, 그 효과를 테스트하고, 작업에 가장 적합한 것을 선택할 수 있습니다.

프롬프트 버전 관리는 피드백 및 결과를 기반으로 프롬프트의 지속적인 개선 및 적응을 가능하게 하여 더 나은 LLM 성능을 이끌어낼 수 있습니다. 또한 사용된 프롬프트의 기록을 제공하여 향후 참조 및 모델 성능의 진화를 이해하는 데 유용할 수 있습니다.

프롬프트의 효과를 평가하는 것은 프롬프트를 생성하는 것만큼 중요합니다. 프롬프트 평가는 LLM이 원하는 출력을 생성하도록 안내하는 다양한 프롬프트의 성능을 평가하는 것을 포함합니다.

이는 다양한 프롬프트에 의해 생성된 출력을 비교하거나, 정확도, F1 점수 및 BLEU와 같은 메트릭을 사용하거나, 사용자 피드백을 통해 수행할 수 있습니다. 정기적인 프롬프트 평가는 선택된 프롬프트가 계속해서 최상의 결과를 제공하도록 보장하고 프롬프트의 정제 및 개선을 가능하게 합니다.

LLMOps 모범 사례

LLMOps의 모범 사례를 구현하면 LLM 성능을 크게 향상시키고 배포와 관련된 위험을 완화할 수 있습니다. 이러한 관행에는 다음이 포함됩니다:

-

모델 평가 및 벤치마킹

-

개인정보 보호 및 규정 준수

조직은 이러한 모범 사례를 준수함으로써 이러한 고급 AI 모델의 잠재력을 최대한 발휘하여 그들의 강력함뿐만 아니라 안전성과 책임감도 보장할 수 있습니다.

프롬프트 엔지니어링

효과적인 프롬프트를 작성하는 것은 LLM이 원하는 출력을 생성하고 작업 성능을 향상시키는 데 필수적입니다. 잘 구성된 프롬프트는 모델이 원하는 출력을 생성하도록 유도할 수 있는 반면, 부적절한 프롬프트는 관련이 없거나 비논리적인 결과를 초래할 수 있습니다.

효과적인 프롬프트를 생성하려면 간결한 언어를 사용하고 모호성을 제거하며 모델이 작업을 이해할 수 있도록 충분한 맥락을 제공하는 것이 좋습니다.

검색 증강 생성

LLM을 외부 지식 소스와 결합하면 그들의 능력을 향상시키고 지식 부족 문제를 해결할 수 있습니다. 검색 증강 생성은 검색 모델과 생성 모델을 결합하여 보다 정확하고 다양한 출력을 생성하는 기술입니다.

이 접근 방식은 LLM의 지식 격차를 메우고 다양한 작업에 대해 더 정확하고 관련성 있는 출력을 생성할 수 있도록 합니다.

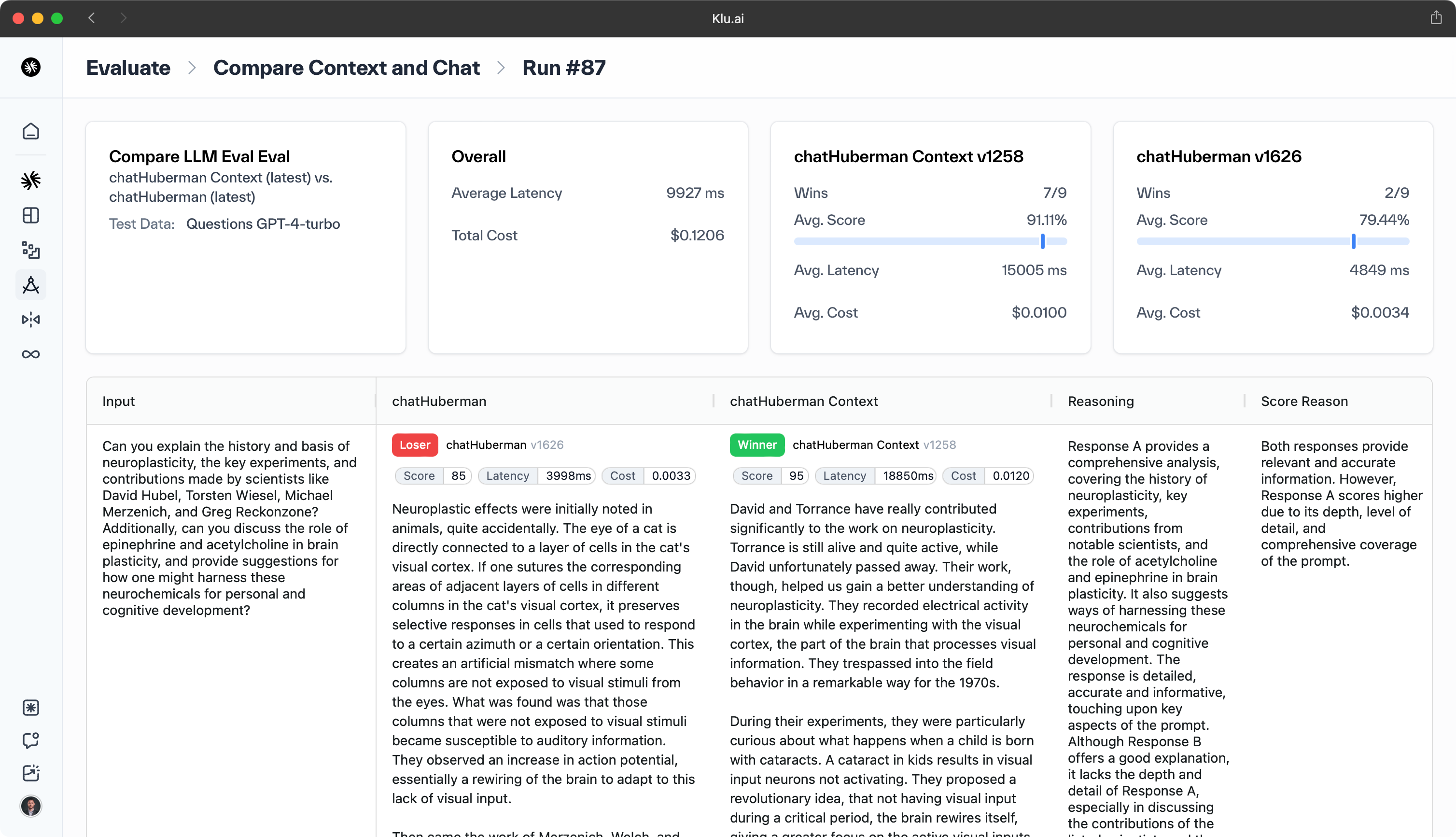

모델 평가 및 벤치마킹

적절한 메트릭과 벤치마크를 사용하여 LLM 성능을 정기적으로 평가하는 것은 품질을 유지하고 문제를 해결하는 데 중요합니다. 정확도, F1 점수 및 BLEU와 같은 메트릭에 대한 모델 성능 평가를 통해 성능 관련 문제를 감지하고 수정할 수 있습니다.

llmops

model outputs

model drift

model outputs

model outputs

large language models

model performance

foundation model

large language models llms

large language model operations

model management

data management

model training

model outputs

vector databases

model drift

robust data management practices

ml models

sensitive data

improve model performance

deep learning models

model deployment

machine learning lifecycle

model optimization

model evaluation

model development process

machine learning

model architecture

continuous model monitoring

deliver higher quality models

fine tuning

model monitoring

prompt engineering

model and pipeline development

ethical model development

ai models

retrieval augmented generation

optimizing model training

rest api model endpoints

optimizing model latency

model review

efficient model management

continuous integration

exploratory data analysis

smooth and efficient workflow

machine learning models

reinforcement learning

training data

data storage

model and pipeline lineage

data collection

natural language processing

automate data collection

prompt templates

data labeling

human feedback

only well performing models

multiple llm calls

model development

performance metrics

higher quality models

data teams

model availability

pre trained

machine learning projects

foundation models

models effectively

model inference

computational power requirements

new data

model security

language models

model latency

distributed training

domain specific data

track model

seamless model updates

classical ml models

external system interactions

access controls

machine learning operations

model fine tuning

complex tasks

fine tune models

모델의 성능을 다른 모델 및 업계 벤치마크와 비교하면 모델 성능 및 최적화를 개선할 수 있는 귀중한 통찰력을 제공할 수 있습니다.

개인정보 보호 및 규정 준수

LLMOps에서 데이터 프라이버시와 규정 준수를 보장하는 것은 중요합니다. 취해야 할 몇 가지 주요 단계는 다음과 같습니다:

-

데이터 세트에서 개인 식별 정보를 제거하기 위한 익명화 기술 구현

-

GDPR 및 CCPA와 같은 데이터 보호 규정을 준수

-

민감한 데이터를 보호하고 책임 있는 LLM 배포 보장

정기적인 감사 및 평가는 지속적인 준수 및 보안을 보장하는 데 중요합니다. 이는 높은 수준의 데이터 보호가 유지되고 강력한 모델 관리가 유지되도록 보장합니다.

LLMOps를 위한 도구 및 플랫폼

다양한 오케스트레이션 플랫폼, 프레임워크, 라이브러리 및 관측 도구는 LLM의 개발, 배포 및 지속적인 관리를 간소화하여 LLMOps를 지원합니다. 이러한 리소스는 데이터 과학자와 엔지니어가 LLM 배포의 복잡성을 효과적으로 해결하고 다양한 애플리케이션에서 최상의 성능을 유지할 수 있도록 합니다.

모델 오케스트레이션 플랫폼

Databricks 및 Hugging Face와 같은 오케스트레이션 플랫폼은 데이터 관리, 모델 튜닝, 배포 및 모니터링을 포함하여 LLM 관리를 위한 전체 수명 주기를 간소화합니다. 이러한 플랫폼은 팀이 데이터를 효율적으로 처리하고, 실험을 수행하고, 모델 및 파이프라인을 개발하고, 정밀하고 제어된 방식으로 배포할 수 있는 협업 환경을 조성하여 LLM을 프로덕션 워크플로에 원활하게 통합할 수 있도록 합니다.

프레임워크 및 라이브러리

TensorFlow 및 PyTorch와 같은 오픈 소스 프레임워크는 LLM 개발을 간소화하여 모델 구축, 미세 조정 및 배포를 위한 필수 도구를 제공합니다. 이러한 프레임워크는 확장 가능한 생산 등급 파이프라인의 생성을 지원하여 다양한 애플리케이션에 대한 LLM의 효율적인 관리 및 배포를 가능하게 합니다.

관측 및 유지 관리 도구

Klu와 같은 관측 및 유지 관리 도구는 LLM의 실시간 모니터링에 필수적이며, LLM의 건강과 성능을 보장합니다. 이러한 도구는 팀이 문제를 신속하게 식별하고 해결할 수 있도록 하여 다양한 애플리케이션에서 LLM의 품질과 성능을 유지하는 데 중요합니다.

LLMOps의 실제 적용

LLM과 LLMOps는 다양한 산업 및 사용 사례에 적용되어 이러한 강력한 AI 모델의 다재다능함과 잠재력을 보여줍니다. 의료에서 AI 비서, 챗봇에서 프로그래밍, 교육에서 데이터와의 대화형 애플리케이션, 판매에서 SEO에 이르기까지 LLM은 우리가 AI 기술과 상호작용하고 활용하는 방식을 재정의하고 있습니다.

다음 하위 섹션에서는 다양한 분야에서 LLM과 LLMOps의 변혁적 영향을 보여주는 실제 응용 사례를 살펴봅니다.

AI 비서

LLMOps는 AI 비서와 챗봇을 크게 향상시켜 보다 자연스럽고 대화형 상호작용을 가능하게 하여 원활한 사용자 경험을 제공합니다. 또한 챗봇이 정확하고 개인화된 지원을 제공하여 다양한 분야에서 고객 만족도를 높일 수 있도록 합니다.

챗봇

LLMOps는 챗봇 개발 및 관리를 혁신하여 성능과 유용성을 향상시켰습니다. 간소화된 모델 훈련, 패키징, 검증 및 배포 프로세스를 통해 챗봇은 이제 사용자와 더 정확하고 개인화된 상호작용을 할 수 있습니다. 이러한 발전은 기업이 고객 서비스를 개선하고 운영을 최적화하며 성장을 촉진하여 고객 경험을 향상시킬 수 있도록 합니다.

데이터 Q&A

LLM과 LLMOps에 의해 강화된 데이터와의 대화형 애플리케이션은 산업이 빅데이터와 상호작용하는 방식을 변화시키고 있습니다. 데이터와의 자연어 대화를 가능하게 함으로써 이러한 애플리케이션은 패턴, 트렌드 및 통찰력을 신속하게 식별할 수 있도록 합니다. 그 결과, 생산성, 효율성 및 고객 만족도를 향상시키는 간소화된 의사 결정 프로세스가 이루어집니다.

LLMOps 플랫폼

LLMOps는 대형 언어 모델의 수명 주기를 관리하기 위해 다양한 도구를 활용합니다. 다음은 LLMOps 도구의 몇 가지 예입니다:

-

Klu.ai — 야심 찬 스타트업과 기업을 위한 완전한 앱 수명 주기 LLMOps로, 프롬프트 및 모델 개선을 위한 지속적인 피드백 수집과 LLM 기반 데이터 라벨링에 중점을 둡니다.

-

Weights & Biases (W&B) — 이 플랫폼은 MLOps 플랫폼 내에서 LLMOps 도구 모음을 제공합니다. LLM 실행 흐름 시각화 및 검사, 입력 및 출력 추적, 중간 결과 보기, 프롬프트 및 LLM 체인 구성의 안전한 관리 기능을 포함합니다.

-

Amazon SageMaker — 데이터 과학자와 개발자가 기계 학습(ML) 모델을 신속하게 구축, 훈련 및 배포할 수 있는 완전 관리형 서비스로, LLMOps의 맥락에서 사용할 수 있습니다.

LLM을 사용한 프로그래밍 작업의 자동화는 소프트웨어 개발 프로세스를 혁신할 잠재력을 가지고 있습니다. LLMOps의 도움으로 LLM은 코드 스니펫을 생성하고, 버그 수정을 자동화하며, 사용자 입력에 기반하여 전체 애플리케이션을 생성할 수 있습니다.

이는 개발 프로세스를 간소화할 뿐만 아니라 개발자가 더 복잡하고 가치가 높은 작업에 집중할 수 있도록 하여 소프트웨어 개발의 품질과 효율성을 궁극적으로 향상시킵니다.

결론

LLM과 LLMOps의 통합은 AI가 우리의 일상 활동에서 수행하는 역할을 강화하여 다양한 분야를 재구성하고 있습니다.

LLMOps는 LLM의 복잡성을 해결하고 다양한 애플리케이션에 대한 성능을 최적화합니다. 이 시너지는 조직의 성장, 운영 효율성 및 개선된 결과를 촉진합니다.

LLM과 LLMOps가 발전함에 따라, 그들은 우리의 삶에 AI를 더욱 통합하고 혁신을 주도하며 우리가 상호작용하고, 일하고, 문제를 해결하는 방식을 개선할 것을 약속합니다. 미래의 영향에 대한 더 깊은 이해를 위해, 우리의 LLMOps 미래 통찰력을 방문하십시오.